von Rudi Kulzer

auf der Basis einer Pressemeldung

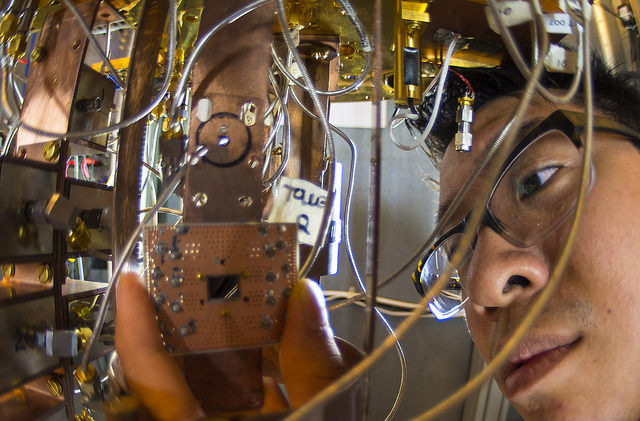

Das Wissenschaftsmagazine „Nature Communications“ berichtet in seiner Ausgabe vom 29. April 2015, dass Wissenschaftler des IBM Thomas J. Watson Research Centers in Yorktown Heights und Zürich erfolgreich einen Schaltkreis aus vier, in einem quadratischen Gitter angeordneten Quantenbits entwickelt. Dieser entspricht der kleinsten vollständigen Einheit eines skalierbaren Quantencomputers mit Quantenfehlerkorrektur.

Die IBM Forscher konnten mit ihrer Arbeit erstmals die zwei Arten von Quantenfehlern (so genannte Bit-flip- und Phase-flip-Fehler), die in jedem Quantencomputer auftreten können, erkennen und messen. Bisher war es nur möglich, einen der beiden Fehler zu bestimmen, nicht aber beide gleichzeitig. Diese Fähigkeit ist jedoch notwendig für die Korrektur von Quantenfehlern – einer wesentlichen Voraussetzung für den Bau eines entsprechenden Computers.

Eine der größten Herausforderungen bei der Realisierung von Quantencomputern ist die Kontrolle oder Beseitigung der Dekohärenz, die zu Rechenfehlern führt. Diese können z.B. durch Wärme, elektromagnetische Strahlung oder Störstellen im Material verursacht werden. Solche Fehler sind in der Quantenmechanik besonders gravierend, da Quanteninformationen sehr fragil sind. Um Bit-flip- und Phase-flip-Fehler gleichzeitig zu erkennen, haben die IBM Wissenschaftler vier supraleitende Quantenbits (Qubits) in einem quadratischen Gitter auf einem rund ein Quadratzentimeter großen Chip verbunden. Dabei bildet die Anordnung in einem Viereck eine wichtige Neuerung, da eine lineare Kette von Qubits die gleichzeitige Detektion beider Quantenfehlerarten verhindert. Zudem ließe sich die von IBM gewählte Konfiguration durch den Anschluss weiterer Qubits gut skalieren.

Die Rechenleistung von Quantencomputern eröffnet viele neue Möglichkeiten, um hochkomplexe Optimierungs- und Simulationsprobleme zu lösen, die heute mit keinem Supercomputer berechenbar sind. Könnte man einen Quantencomputer mit nur 50 logischen Qubits bauen, so gäbe es keine Kombination aus Superrechnern der gegenwärtigen TOP500-Liste, die dessen Rechenleistung nachahmen könnte. Logische Qubits sind durch Quantenfehlerkorrektur frei von Dekohärenz und werden durch mehrere physikalische Quibits codiert.

„Quantencomputer haben das Potenzial, die computergestützten Wissenschaften zu transformieren“, sagt Arvind Krishna, Direktor von IBM Research. „Sie werden üblicherweise für die Kryptographie erforscht. Wir sehen jedoch auch ein bedeutendes Einsatzgebiet darin, bisher nicht lösbare Problemstellungen in der Physik oder Quantenchemie zu bearbeiten. Dies könnte etwa der Materialforschung oder Medikamentenentwicklung völlig neue Möglichkeiten eröffnen.“